Big Data y la Ciencia de Datos son las áreas que han venido creciendo y alterando la forma en que se hacen negocios y se toman decisiones. Las grandes cantidades de datos disponibles en la actualidad traen nuevas posibilidades que nunca antes existieron. Por lo tanto, es crucial entender su función, y con una perpectiva de bases de datos bien establecidas y soluciones de Business Intelligence, decidir cuál es el mejor conjunto de herramientas para una situación en particular.

El Inicio: Bases de Datos Relacionales

Según diferentes diccionarios, los datos se refieren a hechos y estadísticas que se recopilan conjuntamente para referencias o análisis. Los datos se convierten en conocimiento procesable solo cuando se han procesado por algoritmos informáticos o por analistas humanos. Hoy en día, los datos se almacenan principalmente en formato digital y se manejan utilizando computadoras. Por lo tanto, con los avances tecnológicos, la cantidad de datos disponibles también ha incrementado significativamente, enfatizando la importancia de la gestión de datos y el análisis. Inicialmente, los datos se manejaban con un sistema de archivos. Sin embargo, el rápido desarrollo de los sistemas informáticos impuso la necesidad de una solución más compleja, estandarizada e independiente.

Durante muchos años, los sistemas de bases de datos relacionales (RDBMS por sus siglas en inglés) se convirtieron en un estándar de facto para la gestión de datos. Gracias a la organización de datos intuitiva dentro de las tablas y los motores de bases de datos integrales, los RDBMS rápidamente ganaron más y más usuarios. Una vez que los datos se representan con un esquema de base de datos, el motor de base de datos realiza una hazaña de álgebra relacional bien definida para permitir el manejo de datos en un alto nivel de abstracción (es decir, utilizando SQL), garantizando la precisión y la consistencia de los datos. SQL, como lenguaje declarativo, elimina la carga de usuarios que escriben código de procedimiento y en su lugar, un motor de base de datos proporciona planes de ejecución de consulta para extraer los datos necesarios. SQL incluye tanto el Lenguaje de Definición de Datos para la creación de estructuras de datos así como el Lenguaje de Manipulación de Datos que se utiliza para la consulta, inserción, actualización y eliminación de los mismos. Es importante destacar que los RDBMS proporcionan propiedades ACID:

- Atomicidad - cada transacción como una sola unidad debe de ejecutarse o fallar completamente

- Consistencia - cada transacción lleva a un estado de base de datos válido que satisface todas las restricciones relacionadas

- Aislamiento - control de concurrencia

- Durabilidad - asegurando la persistencia y la recuperación de datos

Evolucionando hacia el Procesamiento Analítico: Business Intelligence y Minería de Datos

Asegurar las propiedades ACID es computacionalmente costoso, especialmente cuando se realizan transacciones y análisis de datos en paralelo en la misma base de datos. Esto llevó al surgimiento del área de Business Intelligence (BI), la cual se centra en el análisis de datos. Aquí, los datos de las fuentes de datos típicamente internas y controladas se extraen, transforman y cargan periódicamente en un almacén de datos. Los almacenes de datos pueden almacenar datos actuales e históricos que se organizan para facilitar el análisis. Dentro de este contexto, los datos deben ajustarse al esquema en estrella compuesto por las perspectivas de análisis denominadas dimensiones y los datos que se analizan como hechos que contienen medidas. Dicha estructuración de datos también se conoce como cubo de datos, y es la base del Procesamiento Analítico en Línea (OLAP por sus siglas en inglés), donde el cubo de datos se puede navegar con operaciones OLAP como Slice, Dice, Roll-up y Drill-down. Muchos almacenes de datos y soluciones OLAP se construyen sobre RDBMS, representando así el cubo de datos con tablas.

Otro tipo de análisis que se realiza en los diferentes tipos de almacenes de datos es la minería, cuyo objetivo es descubrir patrones en los conjuntos de datos. La minería de datos es un subcampo interdisciplinario de la informática y estadística que involucra diferentes tipos de tareas; éstas incluyen la detección de anomalías, aprendizaje de reglas de asociación, agrupación, clasificación, regresión, etc. Mientras que las soluciones OLAP suelen proporcionar interfaces intuitivas y fáciles de usar para usuarios no técnicos, la minería de datos requiere un nivel relativamente alto de conocimiento técnico, tanto para aplicar los algoritmos como para interpretar el resultado.

El Manejo de Big Data

No todo está escrito en tablas y no todo tiene un esquema predefinido. La generación masiva de datos proveniente de redes sociales, dispositivos móviles, sensores y otras fuentes de datos generó desafíos que motivaron la creación de herramientas y técnicas novedosas. Inicialmente, Big Data se caracterizó por “3 V`s” : volumen, variedad y velocidad. Por lo tanto, enormes volúmenes de diferentes datos y de crecimiento rápido desafiaron a los RDBMS que no se escalan fácilmente debido a las propiedades ACID y los requisitos de esquema fijo. Desde entonces, han surgido muchas “V´s” nuevas, como la variabilidad de los datos, la veracidad, el valor, etc. Esto llevó a la creación de nuevas herramientas y marcos que tienen el propósito de abordar uno o más de los nuevos desafíos. Algunos ejemplos de estas nuevas herramientas incluyen:

- Hadoop – un framework de almacenamiento y procesamiento distribuido.

- Spark – un framework de computación en cluster

- Cassandra – un sistema de gestión de base de datos NoSQL distribuido

- Zookeeper –un servicio centralizado para la gestión de clústeres

- Elastic Search –un motor de búsqueda, etc.

La mayoría de estas herramientas pueden asignarse a uno o más elementos de los sistemas de administración de bases de datos tradicionales. Para esto, es esencial comprender el propósito de cada herramienta /framework y saber cómo combinarlos en una sola arquitectura. Además, los requisitos para las propiedades ACID deben considerarse en función de cada herramienta o framework.

Análisis de Nueva Generación: Ciencia de Datos

Si bien Big Data se enfoca en proporcionar herramientas y técnicas para administrar y procesar grandes y diversas cantidades de datos, no está tan enfocado en interpretar los resultados del procesamiento de datos para respaldar la toma de decisiones. Aquí es donde entra la Ciencia de Datos, enfocándose en el uso de técnicas estadísticas avanzadas para analizar Big Data e interpretar los resultados en un contexto específico de dominio. Por lo tanto, Data Science implica una intersección de varias áreas que incluyen:

- Ingeniería de Datos

- Estadística

- Computación Avanzada

- Visualización

- Dominio y otros

Dentro de este contexto, se requiere de herramientas y frameworks para:

- Programación de estadística

- Bases de datos

- Importación y limpieza de datos

- Análisis exploratorio de datos

- Machine Learning

- Deep Learning

- Minería de textos

- Entendimiento del Lenguaje Natural

- Sistemas de Recomendación, etc.

En general, Data Science se enfoca en brindar una solución integral para obtener información valiosa para respaldar la toma de decisiones en el contexto rápido y heterogéneo de la administración y análisis de datos modernos.

Panorama Actual: Data Lakes

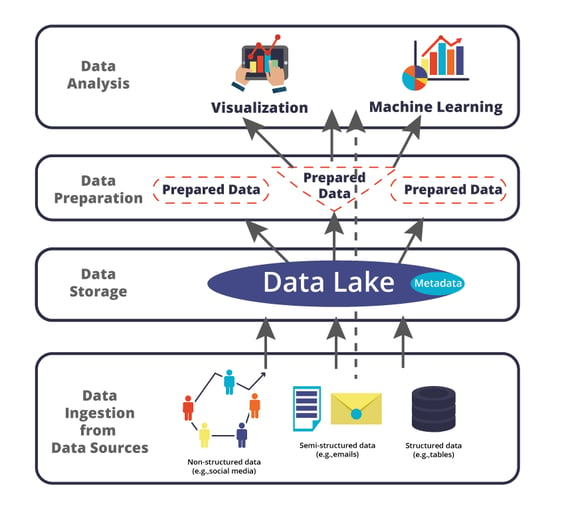

Gracias a las redes sociales, dispositivos móviles personales, sensores y otras aplicaciones y dispositivos de uso intensivo de datos, incluso las pequeñas y medianas empresas tuvieron la oportunidad de obtener grandes volúmenes de datos sobre sus negocios y clientes. Aquí, Data Lake surgió como una solución típica para administrar y analizar Big Data en ese contexto. Como se ilustra en la figura a continuación, cuando se tienen fuentes de datos heterogéneas que incluyen datos no estructurados (por ejemplo, medios sociales) y/o semiestructurados (por ejemplo, correo electrónico), Data Lakes (generalmente una solución basada en HDFS) presenta una gestión de datos flexible donde los datos pueden ser ingeridos. Lo ideal es que Data Lake también pueda incluir una capa de metadatos que describa la organización de datos y la semántica (por ejemplo, mediante el uso de tecnologías semánticas). Una vez recopilados y almacenados, los datos pueden prepararse opcionalmente (por ejemplo, mediante la creación de tablas y / o matrices) para el análisis de datos (por ejemplo, técnicas de visualización o aprendizaje automático). Finalmente, el uso de Data Lake apoya el procesamiento de datos en batch (siguiendo las flechas completas), es decir, los datos se almacenan y luego se procesan para el apoyo de informes, y también se pueden acoplar con los componentes para el procesamiento del flujo de datos (siguiendo la flecha punteada) donde los datos se pueden procesar directamente para admitir el análisis en tiempo real.

Mantenerse al día con las tendencias siempre es difícil en el mundo de los programas informáticos. No importa en qué se centre el negocio, ser competitivo ya no es una cuestión de "solo" entregar un producto o servicio, sino una carrera para brindar la mejor experiencia de usuario a su segmento de mercado. Por lo tanto, tener un conocimiento profundo de los datos que una organización puede obtener de múltiples fuentes y aprovechar el potencial que tiene para impulsar su negocio es la clave para competir y evolucionar.

.png?width=600&height=300&name=Rectangle%20106%20(1).png)